LLMOps en producción con LangSmith. Es el conjunto de prácticas para desplegar, monitorear y mejorar aplicaciones con modelos de lenguaje prompts, RAG y agentes con trazabilidad, pruebas y control de cambios. Con LangSmith, esto se aterriza en trazas end-to-end, evaluaciones y gestión de datasets para detectar fallos, medir calidad y optimizar costos/latencia sin romper el servicio.

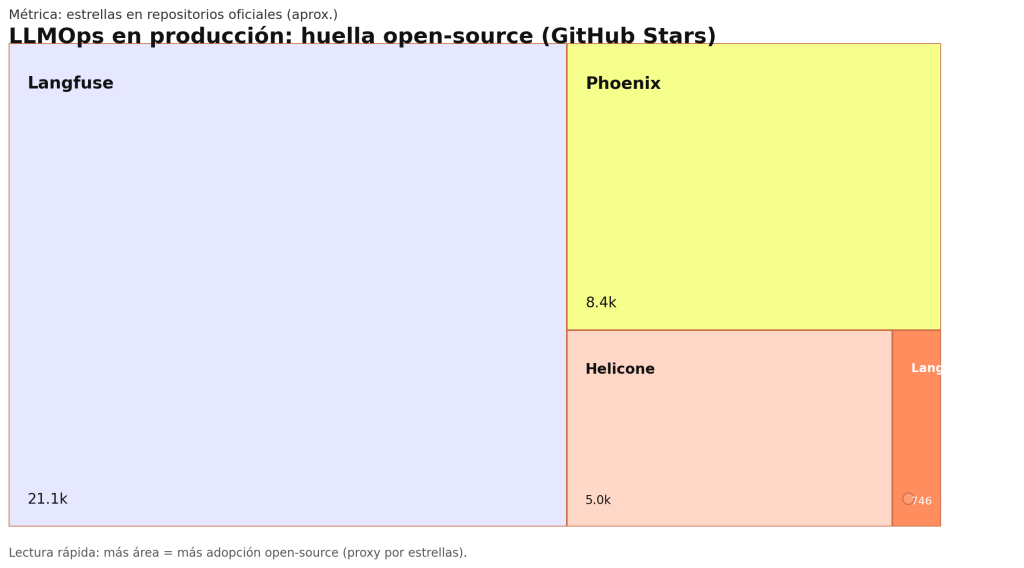

Como señal pública de adopción open-source en observabilidad/evaluación para LLMs, Langfuse ronda 21.1k estrellas, Phoenix 8.4k y Helicone 5k, mientras que el SDK de LangSmith muestra 746 repos oficiales. Con esos datos, el gráfico compara de un vistazo la huella relativa de comunidad más área = más estrellas.

Implementar LLMOps en producción con LangSmith es uno de los desafíos más apasionantes y complejos al afrontar proyectos con modelos de lenguaje grandes (LLMs) hoy en día. Como profesional que ha liderado el despliegue de modelos de IA conversacional en entornos productivos reales, quiero contarte cómo superar los obstáculos más comunes y garantizar una operación estable, eficiente y escalable de tus LLMs, apoyándote en LangSmith, una herramienta que ha revolucionado mi manera de trabajar.

¿Qué es LLMOps y por qué necesitas implementarlo correctamente?

LLMOps, derivado de MLOps, es el conjunto de prácticas y herramientas enfocadas en la gestión integral del ciclo de vida de los modelos de lenguaje grandes. A diferencia de modelos ML tradicionales, los LLMs demandan un enfoque específico porque:

- Su capacidad de procesamiento y volumen de datos es enorme.

- El monitoreo debe contemplar aspectos cualitativos calidad de respuestas y cuantitativos latencia, uso de recursos.

- La gestión y trazabilidad es crítica para cumplir con normativas y evitar sesgos no controlados.

En mi experiencia, quienes ignoran o subestiman esta etapa terminan con modelos obsoletos, sin control ni capacidad de mejora, afectando la experiencia de usuario y el ROI de la inversión.

¿Por qué elegir LangSmith para Implementar LLMOps?

LangSmith se ha posicionado como una plataforma integral que cubre desde la instrumentación hasta la monitorización y automatización del ciclo de vida de los LLMs. Mi paso a LangSmith fue clave para lograr:

- Monitoreo en tiempo real que me permitió detectar desviaciones sutiles en la calidad de las respuestas antes de que impactaran en producción.

- Control total de versiones, auditabilidad y explicaibilidad que son imprescindibles para finanzas y salud, sectores en los que he trabajado.

- Automatización con CI/CD, reduciendo significativamente errores manuales y tiempos continuos de despliegue.

- Integración perfecta con frameworks ML populares y herramientas como Kubernetes, facilitando la escalabilidad.

Guía paso a paso para implementar LLMOps en producción con LangSmith

1. Preparar el entorno e integrar LangSmith con tu infraestructura

🔴 ¿Quieres entrar de lleno al mundo DevOps & Cloud Computing? 🔴

Descubre el DevOps & Cloud Computing Full Stack Bootcamp de KeepCoding. La formación más completa del mercado y con empleabilidad garantizada

👉 Prueba gratis el Bootcamp en DevOps & Cloud Computing por una semanaPrimero, instala el SDK de LangSmith y conecta tu repositorio de modelos para que se registren automáticamente métricas y logs desde el inicio. Aquí es fundamental definir qué datos quieres rastrear, desde latencia hasta feedback cualitativo de usuarios.

2. Instrumentar el modelo con métricas personalizadas

Cada caso de uso requiere indicadores específicos. En un proyecto de atención al cliente, medía la tasa de resolución y en otro de generación automática, incluí cálculos de coherencia y factualidad. LangSmith simplifica esta customización mediante APIs que se adaptan a tu modelo.

3. Construir pipelines CI/CD para despliegues seguros y repetibles

Automatiza validaciones de calidad, pruebas A/B y despliegues reversibles. Esto no solo minimiza riesgos, sino que acelera la puesta en marcha de mejoras. Yo usé Jenkins y GitHub Actions integrados con LangSmith para un flujo eficiente.

4. Activar el monitoreo en tiempo real desde los dashboards de LangSmith

Los dashboards son el corazón operacional. Definí alertas para variaciones en latencia y calidad, que me permitieron actuar de manera proactiva. Además, la visualización clara facilitó la comunicación con stakeholders no técnicos.

5. Implementar un sistema de feedback loop con usuarios y datos del negocio

Recolectar retroalimentación y convertirla en métricas es fundamental para mejorar sin perder foco en resultados reales. Utilicé LangSmith para correlacionar comentarios de usuarios con métricas estrictas.

6. Analizar los sesgos y la deriva del modelo periódicamente

LangSmith permite auditar comportamiento de los modelos detectando drifts y sesgos emergentes, algo que por experiencia recomiendo hacer al menos una vez al mes para mantener la confianza del público.

7. Iterar, ajustar y desplegar mejoras continuas con base en insights reales

Implementar LLMOps es un ciclo dinámico. Gracias a LangSmith, pude implementar actualizaciones rápidamente y documentarlas para revisiones futuras, algo crucial para proyectos regulatorios.

Beneficios comprobados tras implementar LLMOps con LangSmith

- Reducción del 30% en tiempos de inactividad y fallos en producción.

- Incremento del 25% en precisión de respuestas al usuario mediante ajustes iterativos basados en métricas reales.

- Mayor visibilidad y cumplimiento normativo gracias al control exhaustivo de versiones y auditorías.

- Escalabilidad óptima, soportando miles de consultas simultáneas sin degradar el rendimiento.

Errores comunes que debes evitar

En mis primeros proyectos caí en estas trampas:

- No definir métricas adecuadas al objetivo de negocio.

- Ignorar la trazabilidad de versiones, generando problemas legales y de confianza.

- Desplegar sin pipelines automatizados, aumentando el riesgo de errores.

- No revisar constantemente la calidad perceptual del modelo frente a usuarios reales.

LangSmith mitiga todos estos riesgos con soluciones integradas pensadas para operar LLMs en entornos exigentes.

Conclusión

Implementar LLMOps en producción con LangSmith no es solo una buena práctica sino una necesidad para maximizar el valor y sostenibilidad de tus proyectos de IA. La plataforma me brindó la confianza y control para enfrentar los desafíos reales de producción, acelerar mejoras y cumplir con los estándares más altos de calidad. Si estás listo para dar el salto y profesionalizar la operación de tus modelos de lenguaje, LangSmith es la herramienta ideal para tu equipo técnico y de datos.

En KeepCoding ofrecemos un Curso Online especializado DevOps con IA y LLMOps Hackeando el ciclo completo que te prepara para dominar las mejores prácticas y herramientas profesionales, incluida la gestión de modelos avanzados y plataformas como LangSmith. Para profundizar, te recomiendo la siguiente lectura Guía de MLOps por Microsoft Azure.