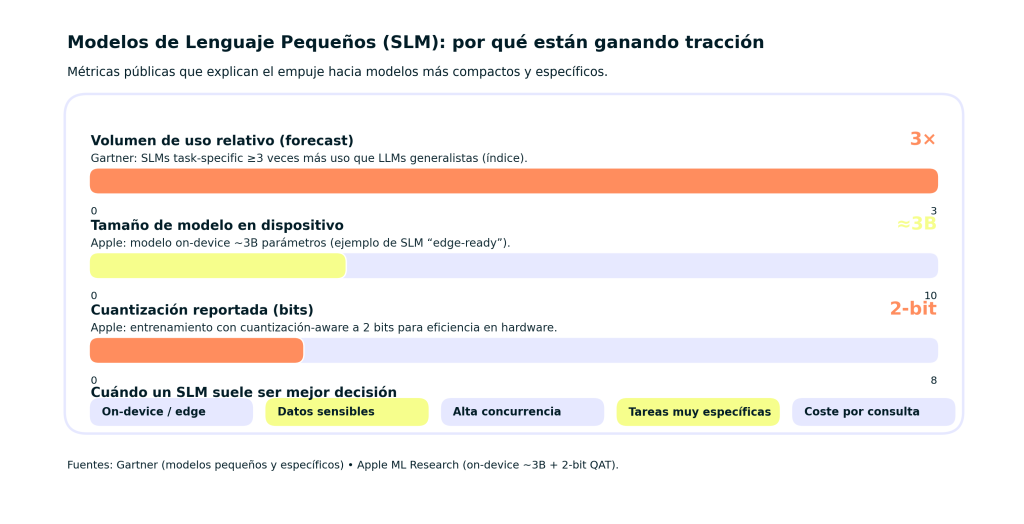

Modelos de Lenguaje Pequeños SLM son modelos de lenguaje más compactos y normalmente más específicos, pensados para resolver tareas concretas con menor costo, latencia y mayor control, ideal para edge/on-device.

Gartner proyecta que, por volumen de uso, las organizaciones usarán modelos pequeños y task-specific ≥3× más que LLMs generalistas. En la práctica, Apple documenta un ejemplo on-device de 3B parámetros y técnicas de eficiencia como entrenamiento con cuantización-aware a 2 bits, mostrando por qué estos modelos encajan en escenarios de privacidad, velocidad y despliegue en dispositivos.

En la era de la inteligencia artificial, escucharás mucho sobre modelos de lenguaje grandes como GPT-4, pero existe una alternativa igualmente fascinante y práctica: los modelos de lenguaje pequeños o SLM. Small Language Models. ¿Te has preguntado alguna vez qué son y para qué sirven? Te comparto mi experiencia trabajando con estos modelos y una explicación sencilla para que comprendas por qué están revolucionando el procesamiento del lenguaje natural. PLN.

¿Qué son los modelos de lenguaje pequeños SLM?

Los modelos de lenguaje pequeños, (SLM) son versiones compactas y especializadas de grandes modelos de lenguaje basados en redes neuronales. A diferencia de los famosos modelos con miles de millones de parámetros que requieren infraestructuras con potentes GPUs y enormes recursos los SLM operan con muchas menos variables, generalmente en el rango de unos pocos millones a decenas de millones de parámetros.

Esto los hace ideales para entornos con limitaciones de hardware, como dispositivos móviles, wearables o sistemas embebidos, permitiendo ejecutar PLN sin conexión y con una velocidad de respuesta mucho mayor. En mi experiencia desarrollando aplicaciones para asistentes virtuales, he comprobado que los SLM son la solución perfecta cuando el entorno no permite un gran gasto energético ni latencias elevadas.

Por qué los modelos de lenguaje pequeños están ganando protagonismo

Es cierto que los grandes modelos de lenguaje son impresionantes en sus capacidades, pero también tienen desventajas claras: consumen mucha energía, son lentos, y su despliegue puede ser costoso.

Aquí entran los SLM, que equilibran precisión y eficiencia de forma efectiva:

- Mayor velocidad: Procesan texto casi en tiempo real, algo fundamental en aplicaciones interactivas.

- Bajo consumo energético: Reducen costos operativos y la huella ambiental.

- Privacidad: Como pueden funcionar localmente, evitan enviar datos sensibles a la nube.

- Facilidad de integración: Son ideales para dispositivos relativamente modestos o con conexiones limitadas.

En proyectos recientes, he visto que optar por un modelo SLM permitió implementar chatbots en dispositivos IoT con recursos muy limitados sin sacrificar calidad en la respuesta, algo que sería imposible con grandes modelos.

🔴 ¿Quieres formarte en Inteligencia Artificial a un nivel avanzado? 🔴

Descubre nuestro Inteligencia Artificial Full Stack Bootcamp. La formación más completa del mercado y con empleabilidad garantizada

👉 Prueba gratis el Bootcamp en Inteligencia Artificial por una semanaCaracterísticas esenciales de los SLM frente a los modelos grandes

| Aspecto | Modelos de lenguaje pequeños (SLM) | Modelos de lenguaje grandes (LLM) |

|---|---|---|

| Tamaño | 1 a 100 millones de parámetros | Miles de millones de parámetros |

| Requerimientos | Bajo consumo CPU y memoria | GPU/TPU potentes y alta memoria |

| Velocidad de inferencia | Alta, aptos para tiempo real | Más lentos, adecuados para tareas complejas |

| Versatilidad | Específicos, destacan en tareas concretas | Multitarea generalista |

| Impacto ambiental | Bajo | Alto |

Estos números pueden parecer técnicos, pero desde un enfoque práctico, implican que los SLM pueden funcionar en tu teléfono sin necesitar conexión constante, algo que muchos desarrolladores ni siquiera consideraban hace unos años.

Aplicaciones prácticas de los modelos SLM

En el mundo real, los SLM se emplean con éxito en numerosos ámbitos, gracias a su equilibrio entre potencia y eficiencia:

- Asistentes virtuales móviles: Para respuestas rápidas y conversacionales sin depender de la nube.

- Análisis de sentimientos y clasificación de texto: En empresas que quieren soluciones eficientes y privadas.

- Sistemas embebidos en vehículos o robots: Donde el hardware está limitado.

- Aplicaciones en salud o finanzas: Donde la confidencialidad de datos es crítica y no se puede confiar plenamente en la nube.

Por ejemplo, en un proyecto de análisis de opiniones de clientes para una empresa pequeña, diseñamos un SLM entrenado específicamente en el tipo de lenguaje y sector, que se ejecuta íntegramente en servidores con recursos limitados. Los resultados fueron sorprendentes, alcanzando una precisión muy cercana a la de modelos más grandes, pero con un coste operativo mucho menor.

Modelos pequeños populares y cómo funcionan

- DistilBERT: Una versión depurada de BERT, logra mantener entre el 95 y 97% de su precisión original con la mitad de parámetros, haciendo más rápido el despliegue.

- TinyBERT: Más ligero que DistilBERT, pensado para dispositivos móviles, muy útil en aplicaciones que requieren mucha velocidad.

- MobileBERT: Optimizado para smartphones y tablets, ofrece un equilibrio sobresaliente entre tamaño y rendimiento.

Los tres modelos mencionados son ejemplos de cómo los SLM no solo reducen el tamaño de los modelos, sino que también aplican técnicas avanzadas de compresión y distilación para mantener la calidad.

Mi experiencia personal con SLM: eficiencia y resultados en la práctica

Personalmente, he participado en proyectos donde comenzamos usando un LLM para prototipos, pero idealmente queríamos lanzar un producto que funcionara de verdad en smartphones sin depender de servidores externos. La transición a un SLM fue clave, no sólo redujo costos, sino que mejoró la experiencia del usuario: las respuestas eran casi instantáneas, y la aplicación podía funcionar offline. Este enfoque me demostró que el futuro pasa por la democratización de la IA, con modelos accesibles y eficientes en todos los dispositivos, no solo en centros de datos gigantes.

Conclusión: ¿Por qué deberías interesarte en los modelos de lenguaje pequeños SLM?

Los modelos de lenguaje pequeños SLM no solo son una opción técnica viable, sino una necesidad creciente en un mundo donde la IA tiene que ser rápida, eficiente y respetuosa con el medio ambiente. Entender qué son y cómo funcionan te brinda una ventaja estratégica para desarrollar aplicaciones de inteligencia artificial capaces de ejecutarse en casi cualquier dispositivo.

Si estás buscando la mejor manera de iniciar o escalar proyectos de IA con procesamiento del lenguaje natural, explorar los SLM es un gran primer paso. Combina precisión, velocidad y economía en un paquete compacto y esa combinación es clave en la creación de tecnologías prácticas que impactan hoy.

Para profundizar en el aprendizaje y dominar este campo en auge, te invito a descubrir los bootcamps especializados de KeepCoding en Bootcamp Inteligencia Artificial Full Stack, donde aprenderás a crear tus propios modelos eficientes y a integrarlos en soluciones de software robustas. Para profundizar, te recomiendo el siguiente recurso. Información técnica y evolución de DistilBERT en Hugging Face.