Qué es un token en ChatGPT: Un token en ChatGPT es una unidad mínima de texto, parte de una palabra, una palabra, un signo o un espacio que el modelo usa para leer tu entrada y generar la respuesta.

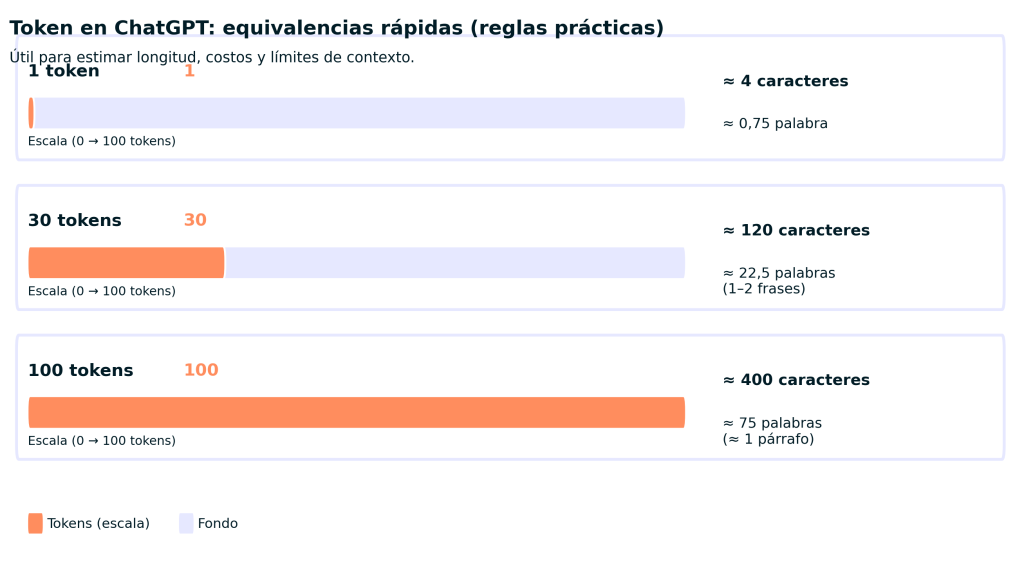

Según OpenAI, como regla práctica en inglés: 1 token 4 caracteres, 1 token ¾ de una palabra, 100 tokens 75 palabras y 1–2 frases 30 tokens (útil para estimar longitud y límites).

Si alguna vez te has preguntado ¿qué es un token en ChatGPT?, estás a punto de descubrir un concepto clave para entender cómo funciona esta inteligencia artificial y cómo sacarle el máximo partido. Como alguien que ha trabajado directamente con modelos de lenguaje y ha optimizado el uso de ChatGPT para proyectos profesionales, te explicaré de forma clara y sencilla qué son los tokens, por qué importan y cómo puedes gestionarlos para mejorar tus interacciones con esta herramienta.

¿Qué es un token en ChatGPT? Entendiendo la unidad básica del lenguaje

Un token en ChatGPT no es necesariamente una palabra completa, sino la mínima unidad de texto que el modelo identifica para procesar y generar respuestas. Puede ser una palabra, una parte de ella, un espacio o incluso un carácter especial como signos de puntuación.

Por ejemplo, la frase ChatGPT es increíble se descompone en tokens como Chat, G, PT, es, in, cr, íble. Esta segmentación se realiza mediante un tokenizador que interpreta cómo dividir el texto de entrada y salida.

Esto significa que el modelo no lee palabra por palabra, sino token por token. Comprender esto es fundamental para balancear la longitud y precisión de tus consultas.

🔴 ¿Quieres formarte en Inteligencia Artificial a un nivel avanzado? 🔴

Descubre nuestro Inteligencia Artificial Full Stack Bootcamp. La formación más completa del mercado y con empleabilidad garantizada

👉 Prueba gratis el Bootcamp en Inteligencia Artificial por una semanaCómo funcionan los tokens en ChatGPT: un vistazo práctico

Desde mi experiencia usando ChatGPT a diario, he comprobado que el comportamiento y capacidad del modelo están directamente sujetos al manejo de tokens: tanto los que envías en la pregunta (prompt), como los que la IA genera en su respuesta.

- Límites de tokens: Por ejemplo, muchos modelos de ChatGPT tienen un tope de aproximadamente 4,096 tokens entre entrada y salida. Si excedes este límite, la interacción puede truncarse o perder contexto.

- Costo por tokens: En entornos profesionales y cuando usamos la API de OpenAI, el cobro se realiza según el número total de tokens procesados. Esto me ha enseñado a ser preciso y evitar textos innecesariamente largos para optimizar costos.

- Calidad de respuesta: Un prompt bien pensado y eficiente en tokens suele generar respuestas más exactas y enfocadas. Evitar redundancias hace que la IA “entienda” mejor tu necesidad.

La importancia de controlar los tokens: contexto y rendimiento

Cuando trabajé en un proyecto de desarrollo de chatbot especializado, aprendí que el control adecuado del número de tokens es vital para que ChatGPT mantenga coherencia en respuestas largas o en conversaciones complejas. Si el contexto de la conversación supera el límite de tokens permitidos, la IA debe “olvidar” partes previas y la calidad del diálogo se resiente.

Además, al tener control sobre los tokens, podemos:

- Optimizar el presupuesto si usamos servicios pagos.

- Evitar tiempos de espera excesivos por respuestas demasiado largas.

- Mejorar la experiencia del usuario con respuestas precisas y relevantes.

¿Cómo se cuentan los tokens en ChatGPT? Detrás del tokenizador

OpenAI implementa un tokenizador basado en técnicas de Byte-Pair Encoding (BPE) que divide el texto según patrones de frecuencia. Esto implica que:

- No siempre un espacio corresponde a un token. Algunas palabras se dividen en varios tokens.

- Caracteres especiales, signos de puntuación y espacios pueden ser tokens independientes.

- En idiomas con palabras compuestas o con acentos, el tokenizador puede fragmentar según reglas específicas.

En la práctica, esto significa que textos aparentemente cortos pueden consumir más tokens de lo esperado, algo que descubrí en varios ensayos cuando diseñaba prompts para proyectos complejos. La herramienta oficial del tokenizador de OpenAI es una gran ayuda para estimar cuántos tokens usarás antes de enviar tus consultas.

Consejos prácticos para optimizar el uso de tokens en ChatGPT

Basado en mi experiencia, aquí algunos tips útiles:

- Sé claro y conciso: Evita rodeos y explicaciones largas en prompts.

- Divide consultas extensas: Si tienes mucha información, divide en partes y administra el contexto paso a paso.

- Usa lenguaje natural pero directo: ChatGPT comprende bien frases simples y directas.

- Prueba con el tokenizador: Antes de enviar tus textos, identifica cuántos tokens usan para no superar límites.

- Evita repeticiones y redundancias: Esto reduce tokens y mejora comprensión.

Si quieres profundizar, te recomiendo explorar cursos de inteligencia artificial como los de KeepCoding, donde explican con detalle cómo funcionan estos modelos y cómo optimizar su uso.

¿Qué pasa si supero el límite de tokens? Consecuencias reales

Cuando en un proyecto me pasé de tokens durante pruebas, comprobé que ChatGPT empezaba a olvidar partes del diálogo anterior. Esto resultaba en respuestas inconexas o poco útiles, lo que me obligó a replantear la estrategia de manejo del contexto y fragmentar las preguntas. Por eso, entender cómo funcionan los tokens en ChatGPT no es solo una curiosidad técnica: es clave para sacarle el máximo provecho.

Conclusión: por qué saber qué es un token en ChatGPT te da ventaja

Entender qué es un token en ChatGPT y cómo gestionarlos ha sido fundamental en mi manejo profesional de esta tecnología. No solo mejora la interacción, sino que reduce costos y maximiza la efectividad de cada consulta. Si quieres sacar verdadero partido a ChatGPT, el primer paso es dominar esta unidad básica del lenguaje que influye en cada respuesta.

Para profundizar y dominar estas habilidades, te invito a revisar el Bootcamp Inteligencia Artificial Full Stack aplicada de KeepCoding. Allí aprenderás no solo sobre tokens, sino cómo implementar soluciones reales y transformar tu carrera profesional en el mundo digital. Para profundizar, te recomiendo el siguiente recurso, Documentación oficial de OpenAI sobre tokenización.