Si planeas convertirte en un experto del Big Data y te encuentras aquí para optimizar tus conocimientos al respecto, ¡estás en el lugar adecuado! Desde KeepCoding te compartiremos cómo funciona una de sus herramientas más utilizadas dentro de Hadoop: el terminal por container Slave.

Conocer cada uno de estos procesos para un análisis efectivo de los macrodatos se ha convertido en algo esencial y ventajoso para quien esté interesado en el universo del Big Data. Por esta razón, a continuación te explicamos qué es el terminal por container Slave y cómo funciona para el manejo de datos.

¿Qué es el terminal por container Slave?

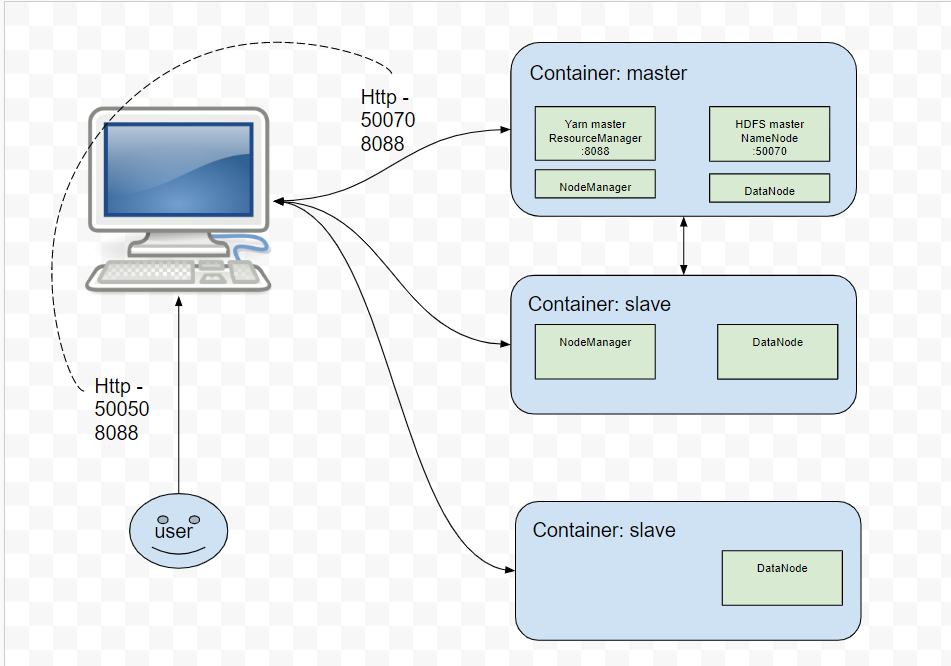

Como primer acercamiento al terminal por container Slave o esclavo (en español), resulta necesario aclarar que se refiere a la instancia en la que llegan los datos que se van procesando en el container Master. Estos dos espacios trabajan de la mano; de hecho, el container Slave es un trabajador del Master, puesto que este último se encarga de administrar los nodos que posee el terminal por container Slave.

En la siguiente imagen se muestra cómo funciona internamente:

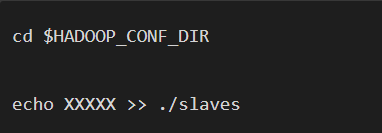

Por otra parte, los nodos slave se nombran con una numeración secuencial, como se muestra a continuación:

Ejemplo del terminal de container Slave

Para ejecutar un terminal de container Slave, deberás aplicar el siguiente comando:

- docker exec -it cluster_worker_1 /bin/bash

Ten en cuenta que este comando de Hadoop de Docker no arranca ningún servicio de manera automática, pero sí logra rellenar los archivos de configuración automáticamente utilizando variables de entorno.

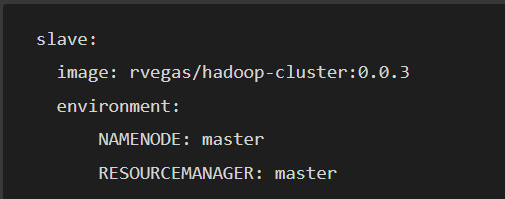

Las variables de entorno se utilizan para configurar las máquinas esclavo. Con esta línea de código del docker-compose se indica de la siguiente forma:

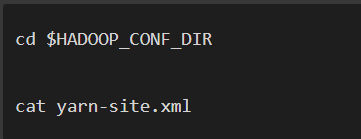

Posteriormente, podrás verificar en el Master y en Slave que se encuentran los ficheros de configuración correctos con el siguiente comando:

Por último, lo único que queda es mandarle a la máquina Master cuáles son los hostnames de las instancias que puede usar como parte del clúster.

Para ello, deberás editar el archivo Slave del directorio de configuración de Hadoop. De esta manera, simplemente tendrás que añadir los hostnames del Master y el de uno de los nodos esclavos, como te mostramos a continuación:

Como aclaración, las xxxxx corresponden a cada container ID de cada uno de los workers generado por Docker.

Problemas comunes al ejecutarse

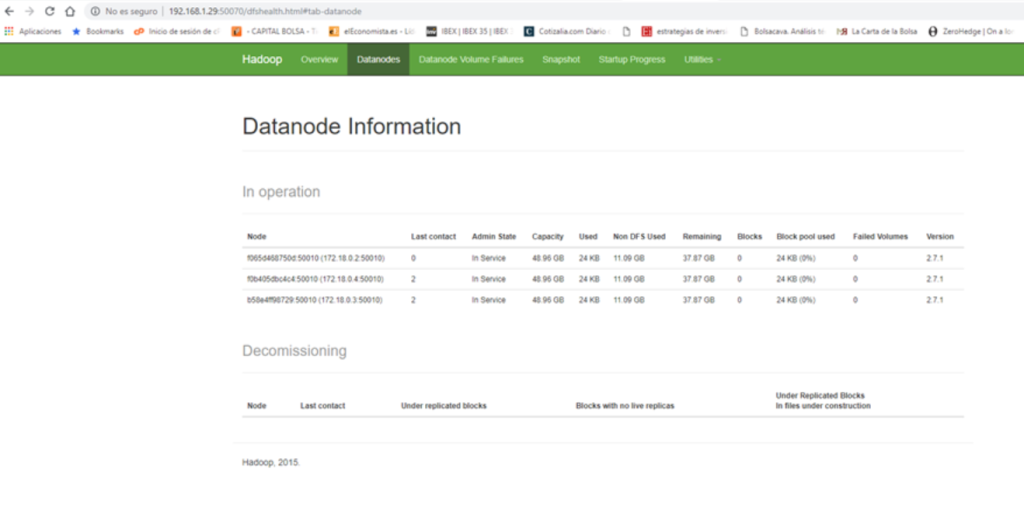

Es posible que, por alguna razón, no encuentres los DataNodes activos en el Dashboard de HDFS. La plataforma se vería así:

En este caso, deberás ejecutar lo siguiente en cada Slave o Datanode:

- $HADOOP_PREFIX/sbin/stop-all.sh

- rm -rf /tmp/hadoop-root/*

- $HADOOP_PREFIX/bin/hdfs namenode -format

De esta manera, te asegurarás de que los DataNodes no tienen configuraciones corruptas de ninguna naturaleza ni aplicaciones de Hadoop ejecutándose.

Finalmente, como última precaución para asegurarlo, puedes hacer lo siguiente en el Master:

- ./sbin/stop-all.sh

- ./sbin/start-all.sh

Por medio de este post, te hemos acercado a lo que es el terminal por container Slave y cómo funciona dentro del mundo Big Data. A pesar de ello, el terminal por container Slave trabaja de la mano con el terminal de por container Master, por lo que te recomendamos tener ambas herramientas en cuenta una vez pienses en implementarlo.

Para aprender más sobre el Big Data y sus herramientas, desde KeepCoding te recomendamos nuestro Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. Gracias a este bootcamp, aprenderás a dominar los conocimientos necesarios para implantar cualquier arquitectura y para la realización de los desarrollos necesarios, tanto técnicos como analíticos, dentro del mundo del Big Data de la mano de grandes profesionales y expertos en la materia. ¡Échale un vistazo a nuestro temario e inscríbete ya!