Los procesos de estandarización en Talend consisten en depurar y limpiar los datos para mejorar su calidad.

En el proceso de depuración de información y limpieza de datos puede suceder que haya columnas con datos que mezclen mayúsculas y minúsculas. Esto debe corregirse, ya que lo que se busca es que, además de subsanar errores futuros que se puedan presentar con los datos, la idea es que los datos sean lo más planos y entendibles posibles.

¿En qué consiste la estandarización en Talend?

Un estándar es un modelo o patrón que se utiliza como referencia y se puede aplicar a otros modelos. La estandarización en Talend es, por tanto, un proceso que consiste en aplicar un patrón o modelo a otros modelos.

En nuestro caso particular, utilizaremos la estandarización para generar características en común entre diferentes flujos de datos y datasets, lo cual nos permitirá aplicar el proceso de un dataset en otros a los que queramos agregarle las mismas características.

Así pues, crearemos un estándar de mayúsculas y minúsculas para las columnas de nombre y apellido del dataset denominado «Potenciales_Clientes». Ahí tenemos una lista de registros, en los que nombres y apellidos tienen mayúsculas iniciales. De modo que aplicaremos mayúsculas sostenidas a todos los registros disponibles en las columnas mencionadas.

Estandarización vs. normalización

En ocasiones, en el proceso de integridad de datos, solemos confundir los términos de normalización y estandarización en Talend cuando estamos ejecutando un análisis o una estrategia de datos.

Hay que aclarar que ambos son conceptos muy distintos y que, dependiendo de las necesidades de scrubbing, se hará uso de uno u otro término.

Normalización de datos

La normalización en Big Data es un proceso que se da cuando no se conoce la distribución de los datos o estos no están distribuidos según los estándares gaussianos. Se utiliza cuando los datos tienen un alcance que no puede ser medido fácilmente y son muy diversos, así como cuando los algoritmos con los que se hacen suposiciones de dichos datos no pueden predecir la distribución de los mismos, como es el caso de las redes neuronales artificiales.

La normalización es útil cuando en las bases de datos no existen valores atípicos, ya que no sabe cómo enfrentarse a estos.

Estandarización en Talend

La estandarización en Talend es un proceso que se utiliza cuando los datos propuestos van a utilizarse para el análisis multivariante, es decir, cuando lo que se busca es comparar todas las unidades variables.

Se aplica cuando los datos tienen curva de campana, esto es, cuando están definidos según los estándares gaussianos. No necesariamente tiene que ser así, pero es más eficaz con datos de este tipo.

Esta técnica es muy útil cuando existe una proporción variable en los datos y los algoritmos que se utilizan hacen predicciones sobre la distribución de datos, como es el caso de la regresión logística.

Generalmente, la estandarización en Talend se usa para trabajar con valores de datos atípicos, ya que no hay un rango definido previamente de características que deban ser transformadas.

¿Cómo ejecutar el proceso de estandarización en Talend?

Para inicializar el proceso de estandarización en Talend entre mayúsculas y minúsculas, lo primero que tendremos que hacer es abrir la base de datos de «Potenciales_Clientes»:

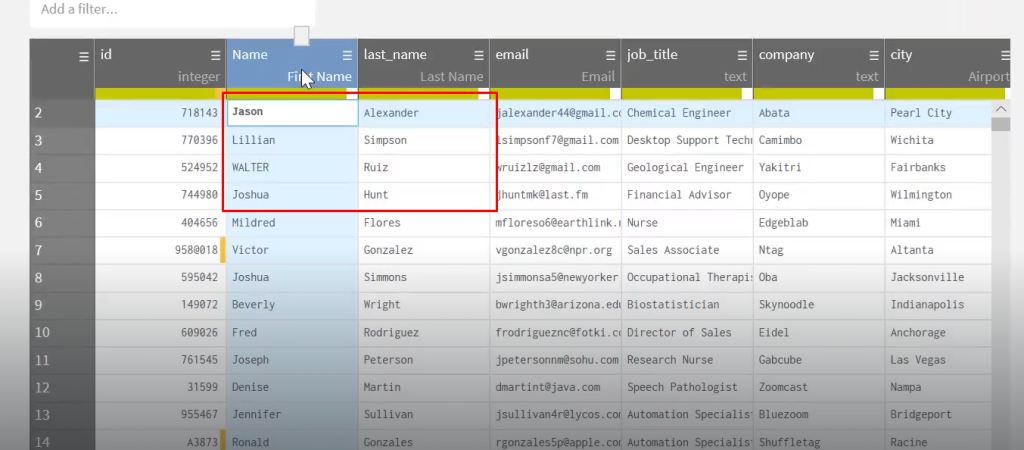

Una vez abierta, comprobamos que la información alojada en las columnas de nombre y apellido debe ser estandarizada, de modo que procedemos seleccionando ambas columnas con ayuda de la tecla Shift.

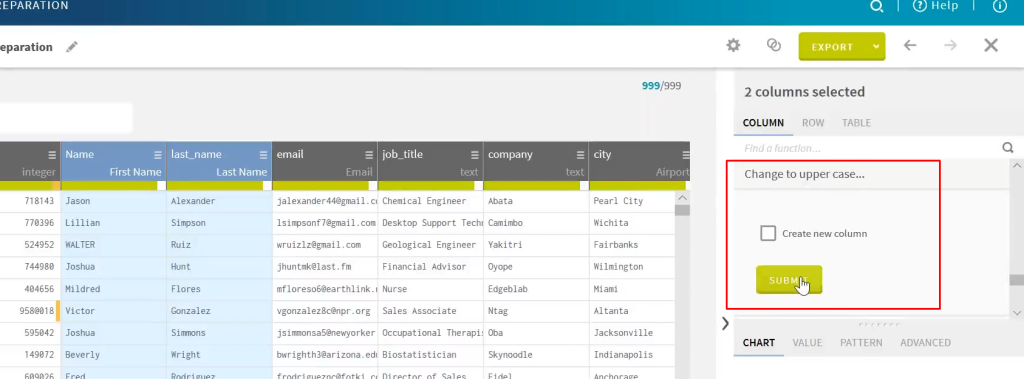

Vamos a observar en el recuadro de sugerencias cuáles son las opciones de estandarización en Talend y escogemos la más adecuada para nuestro caso, que sería «Change to upper case». Hacemos clic en el botón verde que dice «Submit»:

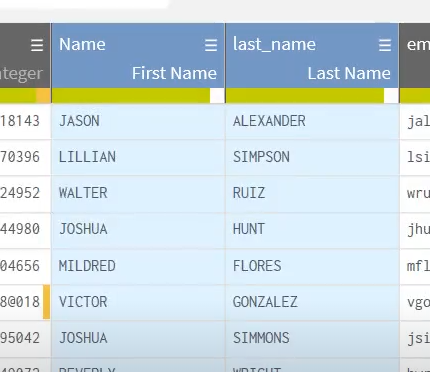

Así, vemos que todos los nombres y apellidos han cambiado a mayúscula sostenida de forma automática:

En este post vimos el proceso de estandarización de datos de las columnas nombre y apellido de una base de datos a la que le hemos puesto valores de campo en mayúscula sostenida. Esto forma parte del proceso de limpieza e integración de datos, en el cual los datos deben quedar listos para usarse en diferentes procesos y que, de este modo, cualquier tipo de persona pueda entenderlos para su uso en la toma de decisiones empresariales.

Recuerda que toda esta temática está incluida de forma más exhaustiva en nuestro Big Data, Inteligencia Artificial & Machine Learning Full Stack Bootcamp. En esta formación, aprenderás sobre los procesos de normalización y estandarización de datos, entre muchas otras cosas. ¡Te esperamos para ayudarte a conseguir tus metas!