El interrogante de qué es Hive es una de las cuestiones básicas en el área de las infraestructuras de almacenaje, ya que esta se ha establecido como una de las más relevantes para el almacenamiento de los macrodatos. De manera que su estudio resulta imprescindible dentro de este campo del procesamiento Big Data.

Una vez te acerques a este tipo de infraestructuras de almacenamiento, podrás facilitar tu procesamiento de los datos y optimizar los resultados arrojados. Por ello, desde KeepCoding te exponemos qué es Hive y cuáles son sus principales características.

¿Qué es Hive?

Hive o Apache Hive es una herramienta de Data Warehousing y ETL (extraer, transformar, cargar) construida para funcionar sobre Hadoop. Se encuentra, más concretamente, sobre el componente de YARN (Yet Another Resource Negociator) y HDFS (Hadoop Data File System).

Además de saber qué es Hive, debes conocer que implementar esta herramienta te permite facilitar tres tareas principales dentro del procesamiento de los datos:

- Análisis tipo SQL de datasets muy grandes: esta es la tarea principal, puesto que es la que permite que se lleve a cabo el procesamiento de los macrodatos, es decir, de una gran volumen de datos.

- Queries Ad-Hoc: Apache Hive te permite generar queries SQL Ad-Hoc (para este propósito), es decir, hacer consultas que solo pueden comprenderse a partir de la misma consultas.

- Encapsulamiento de datos: por medio de Apache Hive podrás contar con el procesamiento de datos que involucra este proceso, que consiste en añadir datos a un paquete. Por tanto, se basa en esta serie de paquetes de los datos para la solución de las peticiones.

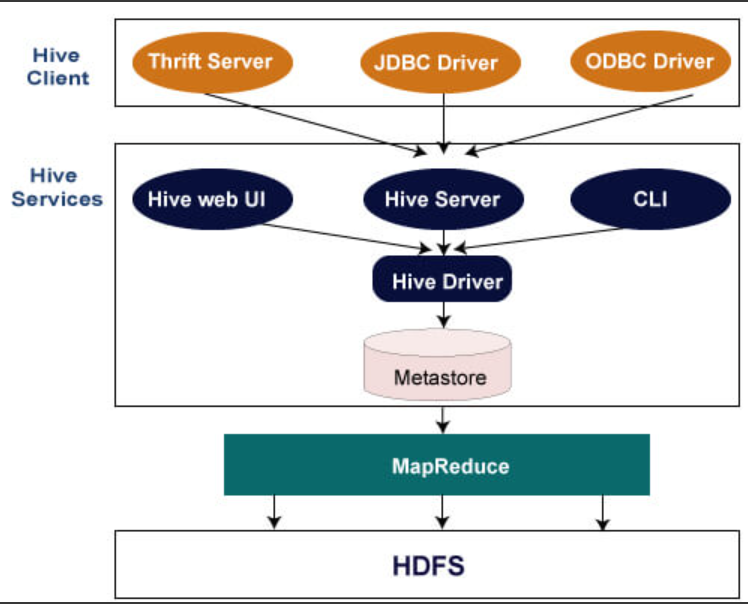

Por otra parte, qué es Hive es comparable a cualquier arquitectura de sistemas de SQL. De hecho, podrás contar con que hay un layer de servidor, en la que se administra el acceso a tablas, al disco, se ceden los permisos a los usuarios, el acceso a los esquemas, etc.

En suma, en Apache Hive existe otro layer que es el cliente, en la que permite conectar al servidor y ejecutar queries, entre otras acciones más complejas de configuración de queries y de almacenamiento.

¿Cuáles son las principales herramientas de Hive?

Apache Hive se sostiene gracias a un conjunto de herramientas fundamentales para llevar a cabo el procesamiento de los datos de tal forma. A continuación, te compartimos cuáles son las principales herramientas o componentes que se emplean por medio de esta infraestructura de Data Warehousing y ETL (extraer, transformar, cargar) sobre Apache Hadoop:

JDBC (Java Database Connectivity)

Por medio de esta API podrás conectarte con una base de datos vía TCP (Protocolo de Control de Transmisión). También existen drivers de JDBC (Java Database Connectivity) para todas los grandes proveedores de bases de datos y para una gran variedad de lenguajes.

ODBC (Open DataBase Connectivity)

Por otro lado, podrás hallar dentro lo que es Hive, la herramienta de ODBC (Open DataBase Connectivity) que es lo mismo que JDBC (Java Database Connectivity), pero abierto. Además, este sistema funciona para otros lenguajes fuera del JVM (Java Virtual Machine). El objetivo principal con este sistema es que sea independiente del sistema operativo y lenguaje sobre el que se ejecuta.

Apache Thrift

Por otra parte, como vuelta de página, Apache Thrift es prácticamente un protocolo que permite pasar objetos en binario a partir de un código generado, como te mostramos a continuación:

- beeline -u jdbc:hive2://localhost:10000

Beeline

Esta proceso forma parte de lo que es Hive y consiste básicamente en ser un simple cliente que se conecta vía JDBC (Java Database Connectivity) a un servidor de HiveServer2. En suma, este se encuentra en los nodos principales por medio del clúster de HDInsight.

Algunas queries simples en Hive

A continuación, te compartimos cuáles son las principales queries simples que podrás desarrollar dentro lo que es Hive:

Para «Mostrar tablas»:

- show tables;

Para «Crear tabla»:

- CREATE TABLE alumnos (id INT, name STRING, last_name STRING);

Para «Insertar datos»:

- INSERT INTO alumnos values(1, ‘ricardo’, ‘vegas’), (2, ‘pedro’, ‘perez’);

- INSERT INTO alumnos values(3, ‘maria’, ‘ochoa’), (4, ‘mario’, ‘gomez’);

Como ejemplo, podrás extraer «Queries» de la siguiente forma:

- SELECT * from alumnos;

Ahora, para insertar muchos datos, deberás seguir los siguientes pasos:

- ctrl+c (salir de beeline)

- apt update

- apt install nano -y

- nano profesores.csv

En el transcurso de este post, te has podido familiarizar con qué es Hive, cuáles son sus principales características y su importancia dentro del mundo Big Data. Aun así, esta infraestructura de almacenaje trabaja con una variedad de herramientas que exigen un mayor estudio al respecto. ¡Desde KeepCoding te traemos la solución ideal!

Nuestro Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning te ayudará a conocer muchos más sistemas, infraestructuras, lenguajes y herramientas que manipulen los macrodatos. Enseñamos por medio de una metodología propia, centrada en enseñar “hands on” lo más importante; además, nos caracterizamos por formar profesionales diferentes, curiosos, cuestionadores, amantes del trabajo bien hecho y buscadores incansables de la autosuperación y del desafío intelectual, con independencia de su área de especialización. ¡Inscríbete ahora!