Las métricas en clasificación son números que miden el rendimiento de un modelo de aprendizaje automático cuando se trata de asignar observaciones a ciertas clases. Generalmente, el rendimiento se presenta en un rango de 0 a 1, donde la puntuación 1 corresponde a un modelo perfecto, clasificado correctamente.

Una de las métricas en clasificación más usadas es el accuracy o métrica de precisión, que muchas veces vemos representado con tres letras: ACC.

En este post veremos algunas generalidades de las métricas en clasificación, para que entiendas cómo funciona este concepto y cómo aplicarlo correctamente en los problemas de tu conjunto de datos en machine learning. No obstante, existen muchas otras métricas en clasificación y hay que tener mucho cuidado en validar cuál usamos en nuestros modelos, porque una mala métrica probablemente se convierta en un mal resultado.

Teoría de la decisión: métricas en clasificación

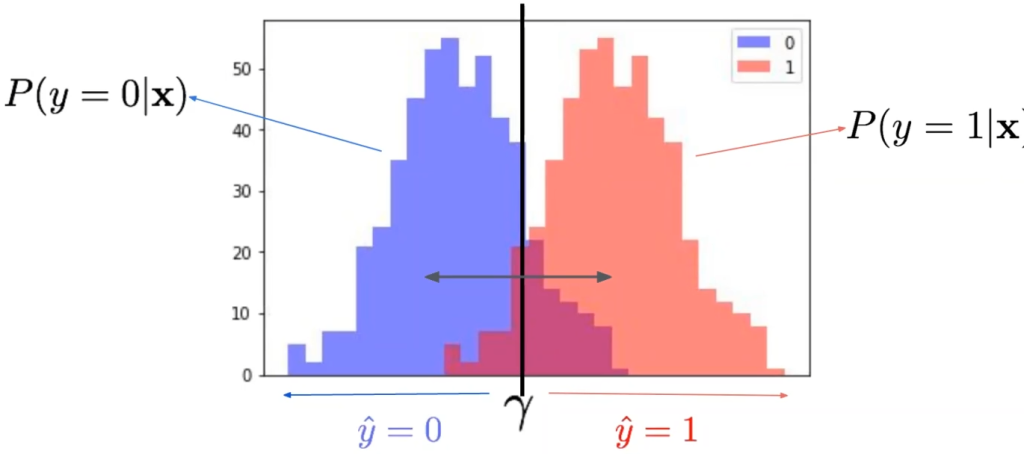

La teoría de la decisión es una de las métricas en clasificación en la que tenemos dos variables: la azul, que corresponde a 0 y tiene la fórmula P (y = 0 l x); y la roja, a la que le corresponde el valor 1 y cuya fórmula es P (y = 1 l x).

Este que se nos presenta pertenece a los problemas de clasificación binaria y la línea negra del centro es un clasificador.

Un clasificador lo que hará en un espacio de dos dimensiones o más (solo que por cuestiones de practicidad no tenemos más de dos dimensiones, ya que no se pueden pintar) es dividir en dos, establecer una frontera y decidir que todo lo que hay a un lado de la frontera es una cosa, por lo que todo lo que hay al otro lado de la frontera es otra cosa diferente.

Entonces, si bien no hay eje x, vamos a asumir que la frontera está, más o menos, en el 0.5. ¿Por qué en este valor? Recordemos que el rendimiento de las métricas en clasificación va de 0 a 1, por tanto, como el clasificador está partiendo los datos más o menos por la mitad, deducimos que la frontera es 0.5.

Si movemos la línea negra al lado izquierdo, se van a tomar más datos o instancias del lado derecho. Si, por el contrario, movemos la línea negra hacia el lado derecho, se van a tomar más instancias del lado izquierdo.

Métricas en clasificación: tasa de error

Una de las métricas en clasificación que existen es la tasa de error. Esta es la métrica más sencilla y su simplicidad radica en que solo se basa en contar errores.

Veamos un pequeño ejemplo para entender mejor el concepto. Tenemos que el True corresponde a las etiquetas reales y el Pred corresponde a las etiquetas predichas. Entonces, la primera etiqueta es un acierto, la segunda es un error, la tercera es un acierto y así sucesivamente con todas las etiquetas.

True: [1 1 0 0 0 0 0 0 0 00 0 0 0 0 1 1 0 0 0 ]

Pred: [1 0 0 0 0 0 0 1 0 0 1 0 0 0 0 1 1 0 0 1]

La tasa de error es el número de errores dividido entre el número de muestras (N).

La tasa de acierto, es decir, el accuracy, es igual al número de aciertos dividido entre el número total de muestras.

- Tasa de error (ERR): número de errores / N

- Tasa de acierto (ACC): número de aciertos / N

- ACC = 1 – ERR

¿Cuál es el problema de esto? Que no hay una caracterización, una identificación del error. Es decir, da igual el sentido del error.

Esto significa que el segundo caso es un error, porque la etiqueta real es un 1 y nosotros estamos prediciendo un 0. Más adelante tenemos otro caso contrario, en donde el original es 0 y la métrica usada nos está arrojando un 1.

En algunos casos esto no importará, pero habrá otros casos en los que el sentido del error sí será relevante para llevar a cabo determinado ejercicio.

¿Quieres seguir aprendiendo?

Para que cumplas tus sueños y sigas aprendiendo sobre el mundo tecnológico, que ofrece grandes oportunidades para desarrolladores y aspirantes a data scientist, tenemos para ti el Big Data, Inteligencia Artificial & Machine Learning Full Stack Bootcamp. En esta formación íntegra e intensiva adquirirás todos los conocimientos teóricos y prácticos para que sigas tu camino hacia el éxito en el mundo IT. ¡No esperes más para cumplir tus metas y solicita información ahora!