Un conocimiento como personalizar el clúster de Dataproc al arranque resulta muy importante dentro del desarrollo del Big Data, ya que este aporta una especificación al procesamiento de los macrodatos. Dentro del mundo del Big Data podrás desarrollar esta personalización en la manipulación de los datos a partir de diferentes herramientas y sistemas, como, por ejemplo, Dataproc o Apache Hive.

En el desarrollo de este post podrás encontrar qué es Dataproc y cómo se personaliza el clúster en Dataproc al arranque. Además, también encontrarás qué es Apache Kafka y cuáles son los scripts de iniciación útiles, que te ayudarán con esta personalización en el procesamiento de los macrodatos.

Personalizar el clúster de Dataproc al arranque

Pues bien, para personalizar el clúster de Dataproc al arranque, en primer lugar, debes encontrarte en la plataforma de este servicio gestionado de Google. Ahora bien, hay una manera más o menos sencilla de lanzar scripts durante la inicialización de instancias de Dataproc que te compartiremos a continuación:

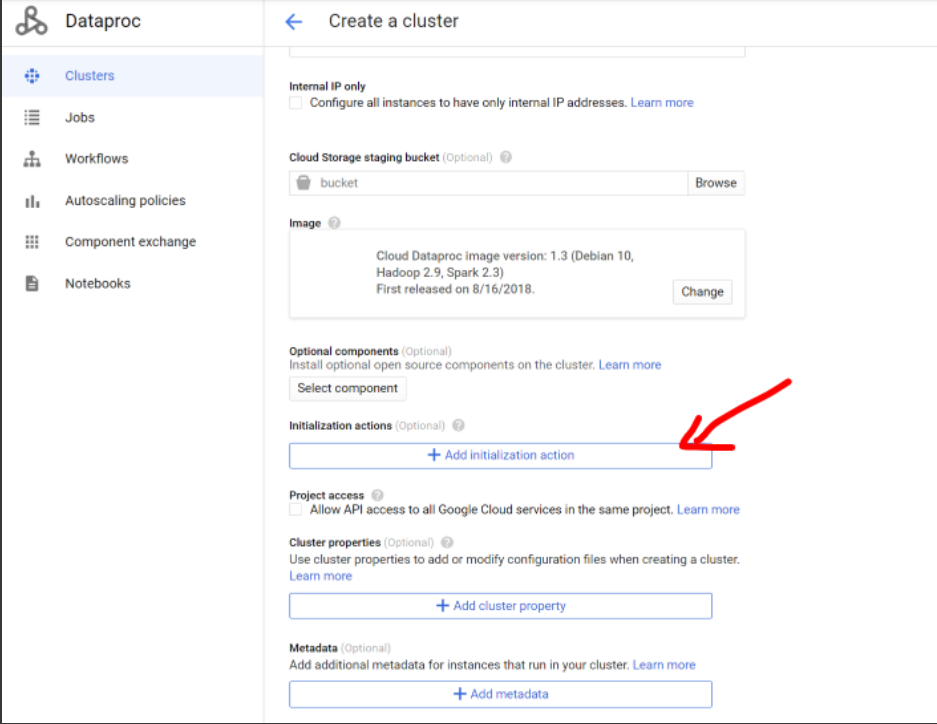

- Como primer paso, podrás entrar a la pestaña de «Create a clúster» o «Crear un clúster» y allí deberás dar clic en «Add initialization action» o «Agregar acción de inicialización».

- Como segundo paso, podrás ver que necesitas tener los scripts en un Google Storage, como se muestra a continuación:

Ahora, para continuar con este proceso de personalizar el clúster de Dataproc al arranque, necesitas conocer qué es Apache Hive, puesto que se utilizará para implementar los scripts de inicialización.

Para personalizar el clúster de Dataproc al arranque debes saber que Apache Hive es una tecnología de Data Warehousing y ETL (extraer, transformar, cargar) que se desarrolla sobre Hadoop, en particular, en el elemento de YARN (Yet Another Resource Negociator) y HDFS (Hadoop Data File System).

Por otra parte, esta herramienta se especializa en tres funciones principales para llevar a cabo el procesamiento de los macrodatos: el análisis tipo SQL de datasets muy grandes, las queries Ad-Hoc y el encapsulamiento de datos.

Algunos scripts de inicialización útiles

Ahora, te exponemos cuáles son los scripts de inicialización para personalizar el clúster de Dataproc al arranque:

1. Duplicar un objeto de storage para evitar que un load data de Apache Hive lo borre:

- gsutil cp gs://bda5-keepcoding-ricardo1/input/airbnb/airbnb.csv gs://bda5-keepcoding-ricardo1/input/airbnb/airbnb_hive.csv

2. Crear tablas y cargar datos en Apache Hive:

- beeline -u jdbc:hive2://localhost:10000 ||:

- CREATE TABLE IF NOT EXISTS airbnb (ID INT, Listing_Url STRING, Scrape_ID STRING, Last_Scraped STRING, Name STRING, Summary STRING, Features STRING) ROW FORMAT DELIMITED FIELDS TERMINATED BY ‘;’;

- LOAD DATA INPATH ‘gs://dataprocessing-ricardo/input/airbnb/airbnb_hive.csv’ INTO TABLE airbnb;

- CREATE TABLE IF NOT EXISTS yelp (name STRING,category STRING, address STRING, city STRING, photos INT, reviews INT, lat DECIMAL(20,10), lon DECIMAL(20,10)) ROW FORMAT DELIMITED FIELDS TERMINATED BY ‘;’;

- LOAD DATA INPATH ‘gs://dataprocessing-ricardo/input/yelp/crawl_hive.csv’ INTO TABLE yelp;

- !quit

La anterior suele fallar, así que es recomendable tener los scripts de Hive en un fichero y llamar al script así:

- beeline -u jdbc:hive2://localhost:10000 -f /tmp/init_hive.txt || :

3. Copiar los ficheros de inicialización de Apache Hive de Google storage al local del clúster:

- gsutil cp gs://bda5-keepcoding-ricardo1/scripts/init_hive.txt /tmp/init_hive.txt

En el transcurso de este post, has podido relacionar cómo se personaliza el clúster de Dataproc al arranque teniendo en cuenta qué es Dataproc, Apache Hive y cuáles son los scripts de iniciación útiles. Sin embargo, como has podido notar, este es un proceso que requiere de un amplio conocimiento sobre el mundo Big Data. Por lo tanto, debes tener presente que es necesario continuar aprendiendo sobre el manejo de los macrodatos y desde KeepCoding te presentamos una gran alternativa!

El Bootcamp Full Stack Big Data, Inteligencia Artifcial & Machine Learning te instruirá en el mundo del Big Data para convertirte en un prosional del sector IT. Con la guía de este bootcamp, podrás llegar a aprender los fundamentos en herramientas y sistemas como el Machine Learning, la Estadística, el Data Mining, la Modern Exploration & Visualization, entre muchos otros que se expondrán por módulos y con el acompañamiento constante de profesionales en el manejo de los macrodatos desde las diferentes alternativas. En suma, este proceso te llevará menos de nueve meses y saldrás con el conocimiento necesario para considerarte todo un experto en el Big Data. ¡No lo dudes más, solicita información y apúntate ahora!