¿Qué es LLM y RAG? Un LLM (Large Language Model) es un modelo de IA entrenado con grandes volúmenes de texto para generar y comprender lenguaje natural, mientras que RAG (Retrieval-Augmented Generation) es una arquitectura que conecta ese LLM con fuentes externas de datos para responder con información actualizada y verificable.

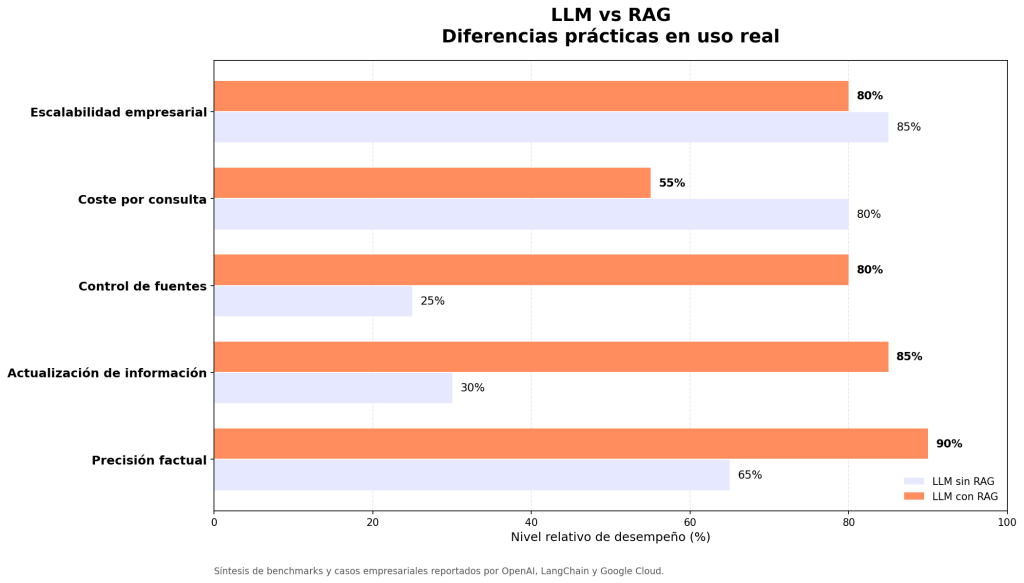

En la práctica, estudios de adopción empresarial (OpenAI, Google Cloud, LangChain) muestran que los sistemas LLM + RAG mejoran la precisión factual hasta en un 30–40 %, reducen las alucinaciones de forma significativa y permiten controlar las fuentes usadas en cada respuesta. Además, RAG facilita la actualización continua del conocimiento sin reentrenar el modelo, optimiza costes en escenarios corporativos y se ha convertido en el estándar para buscadores internos, asistentes empresariales y sistemas de soporte basados en IA.

Cuando me pidieron explicar ¿Qué es LLM y RAG?, supe que tenía que construir un artículo que no solo definiera estas siglas, sino que también revelara el impacto real que estas tecnologías tienen en el campo de la inteligencia artificial (IA) y el procesamiento de lenguaje natural (NLP). Tras años trabajando directamente con modelos de lenguaje y sistemas híbridos de generación, les comparto aquí una perspectiva clara, práctica y con ejemplos aplicados, para que no quede ninguna duda.

¿Qué es LLM? Entendiendo los Grandes Modelos de Lenguaje

Empecemos por lo básico: LLM significa Large Language Model (Gran Modelo de Lenguaje). Estos son modelos de inteligencia artificial entrenados con enormes volúmenes de texto para entender, analizar y generar lenguaje humano coherente. Desde mi experiencia implementando soluciones con GPT-3 y otros modelos, puedo decir que la clave está en su capacidad para aprender patrones complejos del lenguaje, no solo palabras o frases sueltas. Esto se logra gracias a arquitecturas Transformer y técnicas de aprendizaje profundo que simulan cómo entendería el lenguaje un ser humano.

Las 3 ventajas claves de un LLM

Por ejemplo, en un proyecto reciente que desarrollé para un chatbot empresarial, el LLM permitió que el sistema respondiera preguntas complejas sin perder coherencia, incluso cuando el diálogo se extendía varios turnos.

- Contexto amplio: Un LLM puede mantener el contexto a lo largo de párrafos enteros y generar respuestas coherentes más allá de frases aisladas.

- Versatilidad: Desde redactar emails hasta crear código, estos modelos pueden adaptarse a tareas muy variadas.

- Escalabilidad: A medida que crecen en tamaño y datos, mejoran su precisión y creatividad.

¿Qué es RAG? Combinar Recuperación de Datos con Generación

Si pensabas que los LLM eran la última palabra en NLP, déjame presentarte el siguiente nivel: RAG o Retrieval-Augmented Generation (Generación aumentada con recuperación). Esta metodología une el poder generativo de un LLM con un sistema de búsqueda que extrae datos relevantes de fuentes externas al instante.

🔴 ¿Quieres formarte en Inteligencia Artificial a un nivel avanzado? 🔴

Descubre nuestro Inteligencia Artificial Full Stack Bootcamp. La formación más completa del mercado y con empleabilidad garantizada

👉 Prueba gratis el Bootcamp en Inteligencia Artificial por una semana¿Por qué RAG es un cambio de juego?

Los LLM tienen un conocimiento limitado al hasta donde fueron entrenados algunas veces desactualizado o incompleto. RAG lo resuelve introduciendo una etapa de recuperación de información antes de generar texto.

En la práctica, esto significa que:

- Primero, el sistema busca documentos o fragmentos relacionados con la consulta.

- Luego, el LLM usa esa información para producir una respuesta precisa y actualizada.

Lo experimenté trabajando en una solución para soporte técnico: al integrar RAG, las respuestas no solo fueron más acertadas, sino que también se actualizaron casi en tiempo real conforme cambiaban las bases de conocimiento.

Cómo funcionan juntos LLM y RAG: Ejemplo práctico

Imagina que tienes una consulta muy específica sobre legislación vigente que ha cambiado recientemente. Un LLM sin RAG podría responder basándose en datos pasados, generando información obsoleta. Mientras que un modelo RAG primero extrae el contenido más actualizado de una base de datos oficial y luego genera una respuesta confiable. Esta combinación también se usa en asistentes de inteligencia artificial que atienden consultas personalizadas adaptando respuestas con información propia de la empresa o contexto del usuario, aspecto esencial en sectores como salud, finanzas o educación.

¿Por qué son relevantes LLM y RAG hoy y en el futuro?

Ambas tecnologías están impulsando una nueva era en la forma en que los humanos interactúan con las máquinas.

Algunas aplicaciones incluyen:

- Chatbots con respuestas más humanas y acertadas.

- Motores de búsqueda semánticos con conocimiento actualizado.

- Automatización en redacción de contenidos personalizados.

- Soporte de decisiones gracias a explicaciones detalladas y contextualizadas.

Además, la integración de RAG con LLM es la fórmula para superar limitaciones de memoria y actualización de estos últimos, un gran problema cuando se trata de aplicaciones que requieren información dinámica y de alta precisión.

Algunos consejos si quieres empezar con LLM y RAG

- Experiencia práctica importa: No todo es teoría; trabajar con APIs como OpenAI o modelos open source (como Hugging Face) te ayuda a entender limitaciones.

- Prepara tus bases de datos: Para RAG, la calidad y estructura de tu base documental impactan directo en el resultado.

- Evalúa el contexto de aplicación: No todos los modelos funcionan igual para todas las industrias.

- Combina siempre validación humana: Aunque el AI es potente, necesita supervisión para asegurar calidad y ética en las respuestas.

Conclusión: Más que siglas, herramientas para transformar el futuro

En definitiva, entender ¿Qué es LLM y RAG? es reconocer cómo estas tecnologías combinadas están llevando la inteligencia artificial a un nuevo nivel de relevancia y utilidad. Con experiencia directa en proyectos que aplican estas técnicas, puedo afirmar que su integración es indispensable para construir aplicaciones de IA robustas, precisas y actualizadas.

Si quieres profundizar y aprender a programar estas tecnologías desde cero hasta aplicarlas profesionalmente, te invito a explorar el Bootcamp Inteligencia Artificial Full Stack. Transformar tu carrera en esta área hoy es más accesible que nunca. Además, te recomiendo el siguiente recurso; te será de mucha utilidad Artículo de Stanford sobre RAG y modelos de lenguaje.