La regularización en red convolucional es uno de los conocimientos base para el manejo de redes neuronales profundas y avanzadas, puesto que a partir de estos métodos que abarca la regularización se asegura la asertividad de los resultados arrojados en el tratamiento de los macrodatos.

Por este motivo, en el desarrollo de este post, te explicamos qué es y cómo funciona la regularización en red convolucional, de manera que puedas contar con esta optimización en tu estudio del Big Data.

¿Qué es la regularización en red convolucional?

La regularización en red convolucional consiste en penalizar de alguna forma las predicciones que hace nuestra red durante el entrenamiento, de forma que no piense que el training set es la verdad absoluta y así sepa generalizar mejor cuando ve otros datasets.

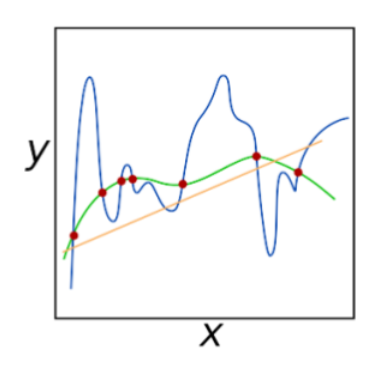

Ahora, para ejemplificar cómo funciona la regularización en red convolucional vamos a fijarnos en esta gráfica de la regularización en red convolucional:

En esta gráfica podemos ver un ejemplo de overfitting, otro de underfitting y otro que es capaz de generalizar correctamente.

¿Cuál es cadauno?

- Azul: over-fitting.

- Verde: buen modelo con capacidad de generalización, es decir, de regularización en red convolucional.

- Naranja: under-fitting.

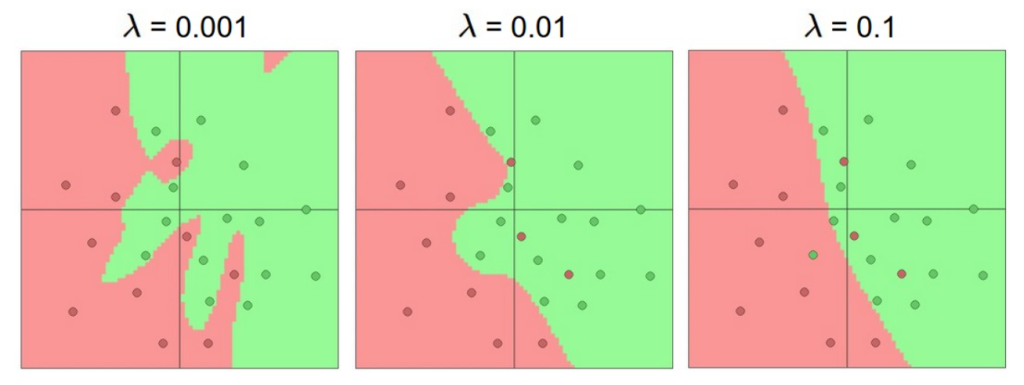

Fíjate ahora en este ejemplo siguiendo con el de antes de las tres redes con diferente número de neuronas. Lo que vemos ahora es la red de 20 neuronas con diferentes niveles de regularización.

Puedes jugar con estos parámetros para ver mejor cómo funcionan.

Al final, es mucho mejor tener una red con muchas capas y aplicarle regularización en red convolucional que tener una pequeña por evitar el overfitting. Esto se debe a que las redes pequeñas son funciones más sencillas que tienen menos mínimos locales, con lo cual el descenso del gradiente llega a uno u a otro dependiendo mucho de la inicialización, por lo que las pérdidas conseguidas suelen tener una gran varianza dependiendo de la inicialización.

Sin embargo, las redes con muchas capas son funciones mucho más complicadas con muchos más mínimos locales que, aunque son más difíciles de alcanzar, suelen tener todos unas pérdidas similares y mejores.

Por otra parte, existen muchos métodos de regularización. A continuación, te vamos a mostrar algunos de los más comunes:

- Regularización L2 (Lasso regularization): la regularización L2 es, posiblemente, la más común.

- Regularización L1 (Ridge regularization): la L1 también es bastante común. En esta ocasión, añadimos el término λ|w| a nuestra función de pérdidas.

- Regularización por restricción (Max norm constraints): otro tipo de regularización es la que se basa en restricciones. Por ejemplo, podríamos establecer un máximo que los pesos no pueden superar.

- Regularización por Dropout: la regularización por Dropout es una técnica desarrollada por Srivastava en su artículo Dropout: A Simple Way to Prevent Neural Networks from Overfitting, que complementa los otros tipos de normalización (L1, L2, maxnorm).

Ahora bien, debes recordar que todavía faltan más métodos para lograr la regularización en red convolucional, por lo que te aconsejamos que practiques con estas y continúes con las demás. Recuerda que estas alternativas potenciarán los resultados arrojados en tu procesamiento de los macrodatos, puesto que esta amplitud hace que el Deep Learning o aprendizaje profundo prepare mejor el desarrollo de la soluciones automáticas en el manejo de las redes neuronales convolucionales.

En el desarrollo de este post, te has podido enfrentar al proceso de regularización en red convolucional, de manera que ya conoces qué es y cómo funciona dentro del procesamiento de los macrodatos por medio del Deep Learning. ¡Esperamos que te animes a llevar este conocimiento a la práctica! Para ello, desde KeepCoding te presentamos nuestro Bootcamp Full Stack Big Data, Inteligencia Artificial & Big Data, una formación intensiva en la que grandes profesionales te ayudarán a tener una visión global del mundo Big Data.

En suma, explorarás de forma tanto teórica como práctica los sistemas que manejan los macrodatos y te convertirás en un data scientist profesional al saber escoger las mejores alternativas para un procesamiento de datos. ¡Apúntate y conviértete en un data scientist profesional en menos de nueve meses!