¿Sabes en qué consiste la regularización Ridge en problemas de overfitting?

Recordemos que la regularización Ridge es bastante similar a la regularización Lasso, ya que ambas introducen un factor de penalización; no obstante, mientras que la regularización Lasso toma la magnitud de los coeficientes del modelo, la regularización Ridge puede ajustar modelos tomando el cuadrado. Esto quiere decir que la regularización Ridge en R acerca los coeficientes de las variables más correlacionadas.

Veamos, por tanto, qué función tiene la regularización Ridge en problemas de overfitting.

Regularización Ridge

La regularización Ridge es un método de ajuste de modelos de machine learning que se utiliza para analizar cualquier dato que sufra de multicolinealidad. Cuando ocurre este problema, los mínimos cuadrados no están sesgados y las varianzas son demasiado grandes, lo que trae como resultado que los valores esperados estén muy lejos de los valores reales y que ocurran problemas de overfitting.

Regularización Ridge en problemas de overfitting

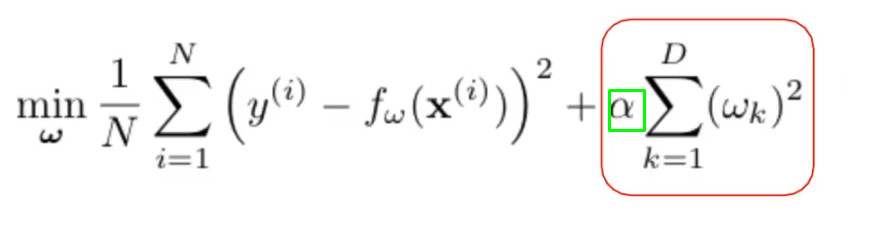

Todo tipo de regularización, especialmente la regularización Ridge en problemas de overfitting, está intrínsecamente relacionado con las matemáticas. Lo que hay detrás de las matemáticas dentro de cualquier ejercicio de machine learning es que se busca disminuir la complejidad del modelo.

La complejidad se puede reducir penalizando los coeficientes altos. Los coeficientes altos se pueden penalizar modificando la función de coste. A su vez, la función de coste la podemos modificar añadiendo un término que es el sumatorio de los coeficientes al cuadrado.

Todo este proceso se hace para que el modelo sea más simple.

El alfa señalado en el cuadrado verde es el parámetro de regularización. Los parámetros de regularización Ridge en problemas de overfitting hay que fijarlos a priori.

Imaginemos que queremos entrenar un modelo y lo vamos a regularizar. Para regularizar ese modelo primero hay que definir en qué medida lo vamos a regularizar. Al fin y al cabo, alfa es esto: si regularizamos mucho el modelo o si lo queremos regularizar poco.

Alfa puede ser 0.01 o 0.99, pero esto es una cosa que tienes que fijar antes. La pregunta es: ¿cómo vamos a hacerlo si estamos entrenando un modelo? ¿Cómo vamos a decidir cuál es el mejor alfa?

El modo de hacerlo es la validación cruzada. Uno de los parámetros libres que vamos a meter en el grid search es alfa; de esta manera, vamos a ejecutar varios entrenamientos, pero en vez de hacerlos nosotros, los hará scikit learn a través de la validación cruzada en nuestro ejercicio de regularización Ridge en problemas de overfitting.

Parámetro de regularización

Si regularizamos muchos, los coeficientes van a ser todos muy pequeños (nulos) y vamos a estar en underfitting.

Si regularizamos muy poco, no va a haber regularización y entonces vamos a estar en overfitting.

- Compromiso entre magnitud de los coeficientes y ajuste de la solución:

- Si α es muy grande → todos los coeficientes nulos (underfitting).

- Si α es nulo → no hay regularización (posibilidad de sobreajuste).

- Ha de fijarse antes (k-fold CV).

- Se cumple que α >= 0.

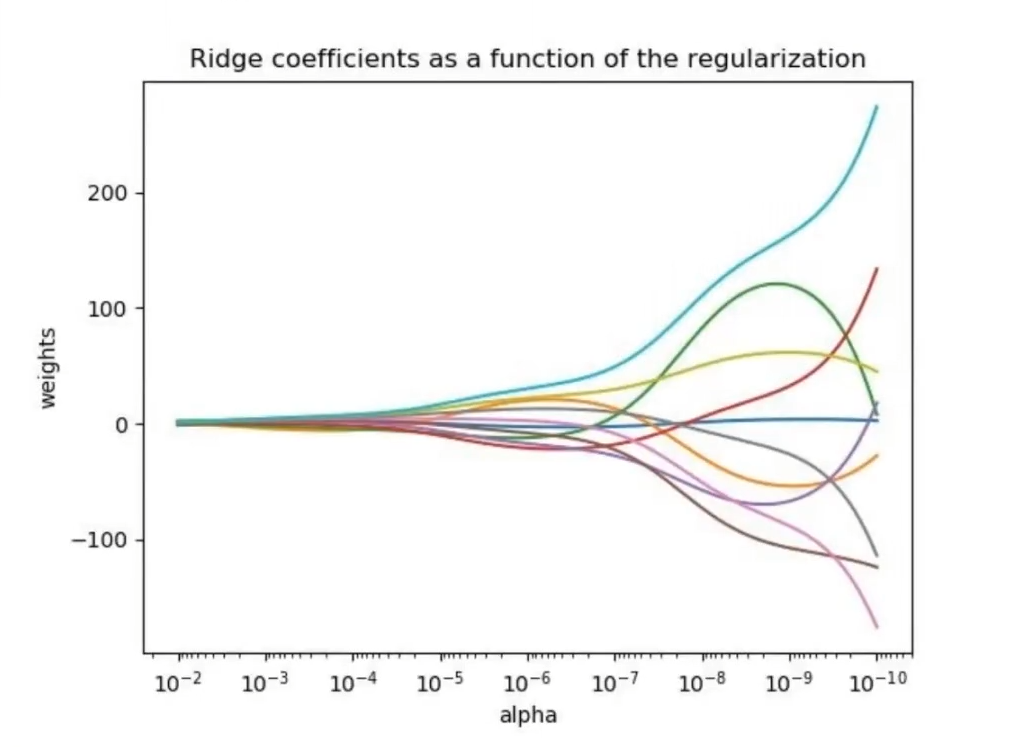

La gráfica anterior representa el valor de los coeficientes en función de la regularización Ridge en problemas de overfitting. Aquí vemos cómo alfa a la derecha es muy pequeño y prácticamente no hay regularización. Con el valor de los coeficientes no se sabe lo que está pasando, no se sabe si es suma o si es resta. Cuando no regularizamos, la suma (asumiremos que esto es una suma) de los radares es muy grande y, a medida que vamos regularizando más, los valores tienden a ceder y encogerse.

¿Cuál sería el punto óptimo? En este caso no lo sabemos, dependería mucho del problema. La única manera de saber esto es meter una serie de estos valores que tenemos, los posibles valores de alfa, y dejar que nos calcule mejor.

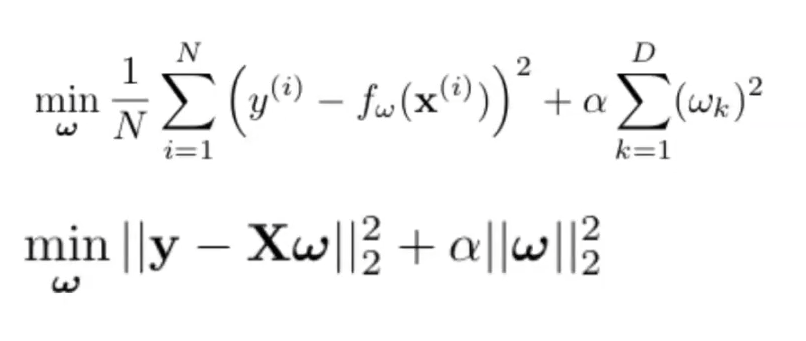

Veamos cuál es la forma matricial de la regresión Ridge:

Así es como se relaciona la regularización Ridge con problemas de overfitting.

¿Quieres seguir aprendiendo?

Si te ha gustado aprender sobre regularización Ridge en problemas de overfitting y te interesaría saber más, puedes unirte a nuestro Big Data, Inteligencia Artificial & Machine Learning Full Stack Bootcamp, una formación intensiva de 8 meses de duración en la que adquirirás toda la fundamentación teórica y práctica y podrás obtener todos los conocimientos necesarios para incursionar en el mercado laboral del Big Data, uno de los más prolíficos y mejor pagados alrededor del mundo. ¡Anímate a cambiar tu vida y solicita más información!