Repositorios de machine learning son espacios como GitHub donde se publica y versiona código de ML, junto con documentación, ejemplos, modelos y pipelines para entrenar/desplegar.

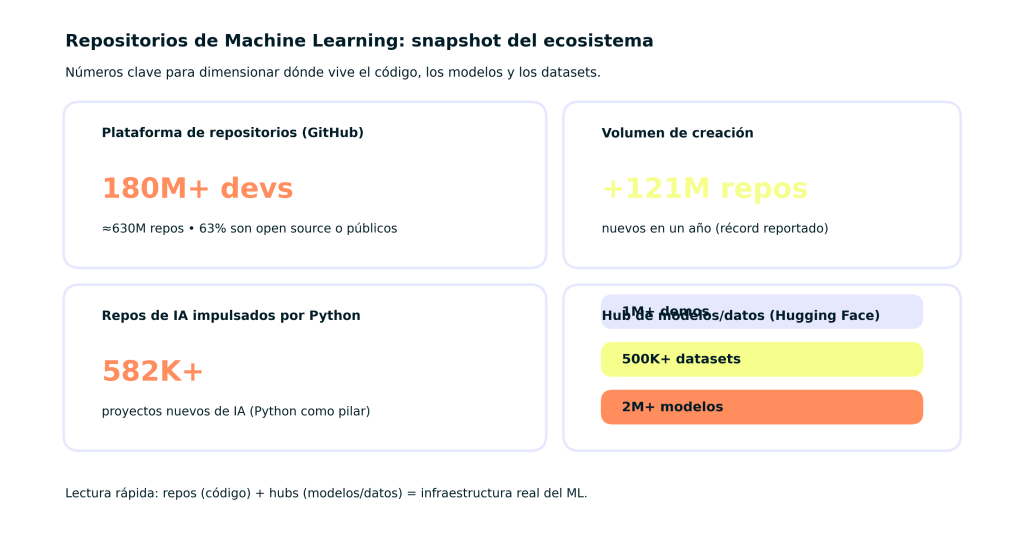

En el último Octoverse, GitHub reporta 180M+ desarrolladores, 630M repos y +121M repos nuevos en un año; además, 63% de los repos son open source o públicos. En IA, se destaca que Python impulsa 582K repos nuevos de IA casi la mitad de los repos nuevos de IA, según el reporte resumido. Y en hubs especializados, Hugging Face documenta 2M+ modelos, 500K+ datasets y 1M demos, que complementan a GitHub como infraestructura de ML modelos/datos listos para usar.

Cuando empecé a formarme en inteligencia artificial, una de las dificultades más grandes fue encontrar repositorios machine learning con datos fiables, variados y listos para usar. No basta con tener conocimiento de algoritmos: los datos son la base para construir modelos sólidos y eficientes. Por eso quiero compartir contigo la experiencia que adquirí explorando y trabajando con distintos repositorios, y cuáles considero los mejores para cualquier nivel, desde principiantes hasta profesionales.

¿Qué es un repositorio machine learning y por qué es clave en tus proyectos?

Un repositorio machine learning es un espacio digital donde se almacenan, organizan y ponen a disposición conjuntos de datos o datasets especialmente diseñados o útiles para entrenar, validar y evaluar modelos de aprendizaje automático. Estos repositorios pueden incluir datos tan diversos como imágenes, texto, cifras estructuradas o series temporales, dependiendo del objetivo del proyecto. En mi trayectoria, comprendí que el acceso a un repositorio adecuado puede acelerar enormemente el ciclo de desarrollo y dar mejores resultados. Pero seleccionar el repositorio correcto implica entender qué tipo de datos necesitas, la calidad de la documentación, las licencias y la comunidad que lo respalda.

Mi experiencia directa: cómo elegir el repositorio ideal

Al avanzar en mis proyectos con diferentes modelos, identifiqué algunos factores decisivos para elegir un repositorio:

- Objetivo del proyecto: Por ejemplo, para un proyecto de clasificación de imágenes, necesitas datasets etiquetados y en formatos estándar como JPEG o PNG.

- Tamaño del dataset: Dataset demasiado pequeño puede provocar sobreajuste; demasiado grande puede ser un problema si no tienes recursos computacionales.

- Documentación completa: Necesitas entender la estructura, variables y contexto de los datos para evitar errores.

- Licencia abierta y permisos: Fundamental respetar derechos; algunos repositorios restringen usos comerciales o modificaciones.

- Comunidad y soporte: Que el repositorio tenga comunidad activa facilita intercambiar soluciones y resolver problemas.

Ahora bien, veamos cuáles son los repositorios machine learning más destacados, combinando tanto los más populares como algunos menos conocidos pero muy útiles.

1. Kaggle Datasets: La comunidad más activa y variada

Mi primera recomendación siempre será Kaggle. En esta plataforma no solo encontrarás miles de datasets para diferentes tipos de problemas, visión por computadora, procesamiento de lenguaje natural, etc., sino también una comunidad que colabora y compite para mejorar modelos.

- Desde datasets pequeños para pruebas rápidas hasta grandes retos del mundo real.

- Notebooks integrados para experimentar sin salir de la plataforma.

- Competiciones regulares que enseñan a optimizar y elevar la precisión.

2. UCI Machine Learning Repository: Clasicismo y rigor académico

El repositorio de la Universidad de California en Irvine es uno de los más fiables y documentados que existen. Lo elegí para mis primeros proyectos de investigación porque sus datasets incluyen explicaciones rigurosas y datos preparados para aprendizaje supervisado. Ideal si hacemos proyectos donde la interpretación y replicabilidad son críticas. Visita UCI Repository

3. Google Dataset Search: Explora millones de datasets en un solo lugar

Si buscas variedad sin limitaciones, probar con Google Dataset Search puede ser una excelente opción. No es un repositorio en sí mismo, sino un motor de búsqueda que indexa recursos desde múltiples sitios. Esto me ayudó cuando necesitaba datasets especializados para casos menos comunes. Pruébalo aquí.

4. Awesome Public Datasets: Colección curada por la comunidad

Este es un repositorio de GitHub que ofrece listas curadas de datasets públicos organizados por categorías. Lo descubrí navegando y me resultó útil para encontrar recursos alternativos poco conocidos.

- Abarca temas de salud, finanzas, ciencias sociales, y más.

- Ideal para proyectos multidisciplinares o exploratorios.

Consulta Awesome Public Datasets.

5. OpenML: Tu laboratorio colaborativo para machine learning

En OpenML, además de acceso a datasets, puedes compartir, reproducir y discutir experimentos científicos. Fue una plataforma clave en mi último proyecto académico donde buscábamos transparencia y colaboración. Descubre OpenML.

6. Amazon Open Data Registry: Datos en la nube para big data

Amazon AWS ofrece una colección de datos abiertos accesibles para análisis en la nube. Puede ser una gran opción cuando trabajas con grandes volúmenes de datos y quieres aprovechar infraestructura escalable. Más información.

7. Data.gov: Recursos oficiales y socioeconómicos para machine learning

Si tu interés se orienta a datos gubernamentales, sociales o económicos, la plataforma estadounidense Data.gov es muy completa y confiable. La usé para proyectos relacionados con análisis de políticas nacionales. Accede a Data.gov.

Claves para sacar el máximo provecho de cualquier repositorio machine learning

- Verifica la limpieza de los datos: Rara vez están listos para usar, prepara tus scripts para limpiar y transformar.

- Analiza la representatividad: Asegúrate que el dataset refleje el problema que quieres resolver.

- Evalúa distribuciones y balance: Sobre todo en clasificación, evita datasets con clases muy desbalanceadas si no es lo esperado.

- Descarga una muestra antes de usar todo el conjunto: Evitarás consumir recursos innecesarios.

Reflexiones finales: más allá de los datos, la mentalidad es lo que importa

Como desarrollador y docente, siempre recalco que contar con repositorios machine learning de calidad es vital, pero nada supera a entender profundamente los datos y el problema. Mi consejo: explora, experimenta y nunca pierdas la curiosidad para adaptar los recursos a tu contexto real.

Si quieres profundizar en machine learning y aplicar conocimientos con datasets reales, te invito a conocer el Bootcamp de Big Data, Data Science, ML & IA Full Stack donde desarrollamos proyectos prácticos desde cero con acceso a estos y otros repositorios, guiados por expertos. Para profundizar, te recomiendo el siguiente recurso. Papers with Code – Líder en benchmarks y datasets de investigación.