El Big Data cada vez se desarrolla más y, dado el crecimiento de la cantidad de datos, también puedes contar con múltiples sistemas y lenguajes para llevar a cabo un manejo y estudio adecuado de dichos datos. Si te encuentras aquí es porque estás interesado en cómo usar Hadoop para el procesamiento de datos y cuáles son sus ventajas al implementarlo.

Ahora bien, dentro del vasto mundo del Big Data, este software se ha posicionado en popularidad gracias a la facilitación que aporta a los repositorios de Data Lakes. Por ello, desde KeepCoding reconocemos esta importancia y, a continuación, te explicamos qué es y por qué usar Hadoop dentro del mundo Big Data y con relación a un repositorio Data Lake.

¿Por qué usar Hadoop?

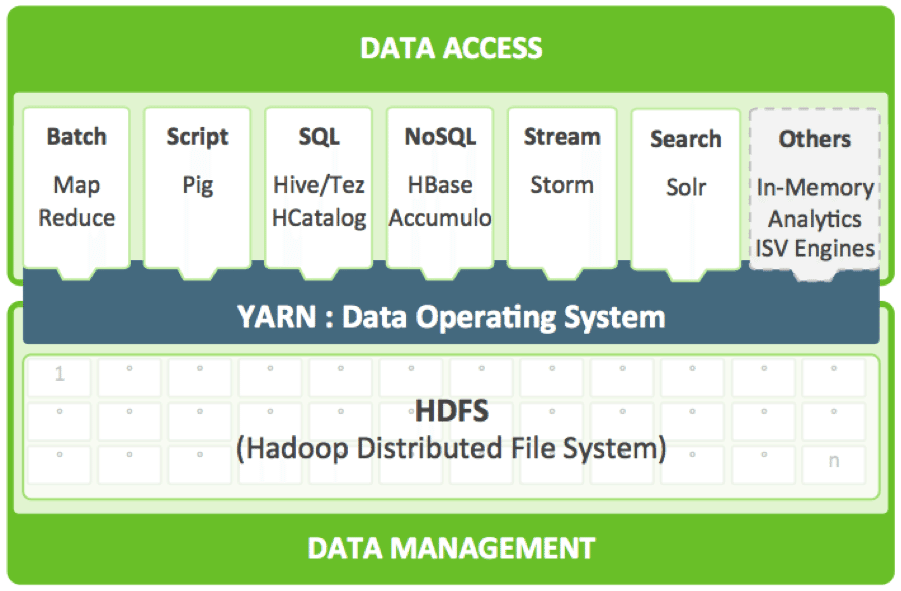

Ahora bien, para saber por qué deberías usar Hadoop, hay que partir de que, gracias a su arquitectura provista por HDFS + YARN + MAP REDUCE, podrás obtener un DAAaS (Analítica de datos como Servicio) «de libro». El desarrollo de su arquitectura internamente se muestra de la siguiente forma:

Como has podido notar, cada uno de sus componentes desarrollan determinadas funciones que se complementan y producen el almacenamiento y procesamiento de diversos tipos de datos. En suma, este estructura facilita la interacción de los usuarios, tiene un bajo coste, es flexible y escalable, todo ello en tiempo real y ágil.

Estas características son lo que potencian usar Hadoop como software en el proceso de almacenaje y gestión de la información. Por otra parte, te comentamos que su uso principal está ligado a los repositorios Data Lake, por lo que es fundamental saber cómo se complementan la serie de componentes de cada una de estas herramientas.

Usar Hadoop y Data Lake

Además de todo lo mencionado anteriormente, Hadoop te brinda las herramientas tecnológicas y la arquitectura para que puedas adaptarlo a muchas situaciones. No obstante, no debes olvidar que hay que sumar todas sus funciones a todo lo que el uso de un Data Lake implica:

- La seguridad: puesto que podrás complementarlo con los criterios que hayas establecido en cuanto a privacidad de los datos.

- La gestión de usuarios: gracias a este, implementarás las estrategias de Hadoop a los parámetros de accesibilidad e interacción de los usuarios con la información.

- Los ciclos de vida/testing: a través del flujo de datos que ofrece un Data Lake, podrás fusionarlo con los principales componentes de Hadoop para potenciar el manejo de los datos.

- Cloud vs on premise: deberás considerar que existen dos formas de acceder a la información: en la nube o en el escritorio. En realidad, de esto se encarga efectivamente el Data Management al usar Hadoop.

- El Gobierno en general: instaurar las leyes para la manipulación de la información ayudará a que ambas herramientas se complementen y optimicen la estructura, la seguridad y el acceso a los datos almacenados.

Por medio de este post, te hemos compartido por qué deberías usar Hadoop y cuál es su importancia dentro del mundo Big Data. No obstante, dentro de todas las herramientas, lenguajes y sistemas del manejo de los macrodatos aún queda mucho más por aprender. Por ello, te aconsejamos encontrar más alternativas para profundizar estos conocimientos y poder desarrollarlos de manera práctica.

Nuestro Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning te permitirá consolidar tus conocimientos y poner a prueba tus destrezas en este ámbito del sector IT. En el transcurso de este bootcamp, aprenderás cómo el Data Mining es la técnica para extraer el conocimiento a través de grandes volúmenes de datos y a utilizar sus métodos de inteligencia artificial, aprendizaje automático, estadística y sistemas de bases de datos. ¿Ya estás pensando en inscribirte? ¡No lo dudes más, inscríbete y empieza ahora!